掌握(cpu核心数为三的技巧

在当前人工智能领域,机器学习模型的性能一直是技术发展的核心驱动力,而如何确保模型在训练和推理过程中达到最佳的效率,成为许多技术人员关注的焦点,一个关键的瓶颈往往隐藏在最基础的硬件配置中——CPU的核心数,如果你的模型训练和推理速度普遍较慢,很可能是因为你的CPU核心数不足,如何在CPU核心数为3的情况下,高效地优化机器学习模型呢?这个问题的答案,掌握在以下几个步骤中。

了解CPU核心数的重要性

CPU的核心数决定了系统执行任务的能力,在机器学习中,训练模型和推理模型的速度直接关系到模型的效率,如果你的CPU核心数较低,即使代码再高效,也只能在有限的计算能力下完成任务。

-

CPU核心数与模型效率的关系

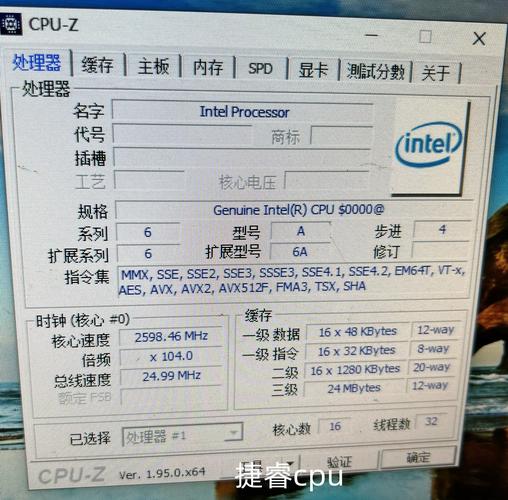

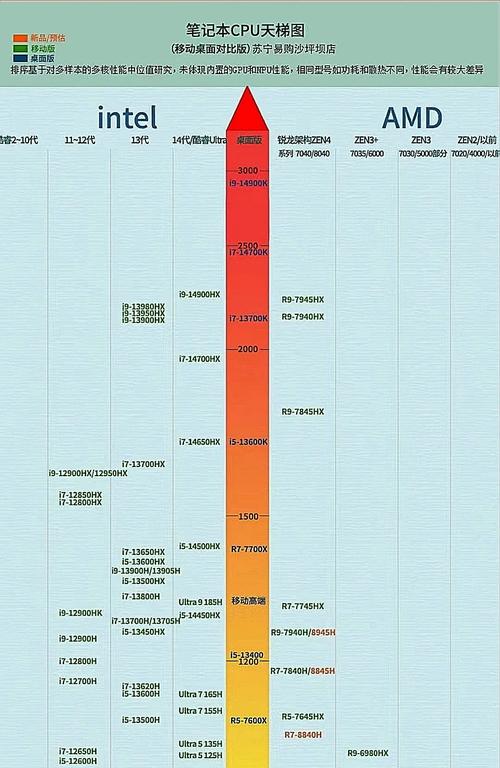

CPU的核心数越多,理论上能够处理的任务数和计算速度也会越高,实际的性能提升往往受到代码效率和算法优化的限制,在优化时需要权衡核心数与性能的关系。(图片来源网络,侵删) -

CPU核心数不足的常见表现

- 在训练过程中,模型训练速度变慢,训练时间延长。

- 理论推理速度下降,推理时间增加。

- 系统响应速度变慢。

-

优化的核心在于提升代码效率

- 编程语言的选择(如C或Python)会影响性能。

- 算法的优化(如使用高效的数学库)也是关键。

决策:CPU核心数为三是否足够?

人们可能会误以为CPU核心数为3就意味着任务无法完成,实际情况并非如此,关键在于任务的复杂性和所需计算量。

-

任务的复杂性与计算量

- 简单的任务(如分类任务)通常可以在较低的CPU核心数下完成。

- 现有模型可能设计得非常高效,能够在较低核心数下运行。

-

模型的特性

- 深度学习模型(如神经网络)通常对计算资源的需求较高。

- 模型的复杂度决定了CPU核心数的必要性。

-

任务的类型

- 数据处理任务(如图像或音频处理)可能不需要太高的计算能力。

- 引入AI推理任务时,推理速度的提升才是关键。

配置代码:优化机器学习模型的效率

配置代码是优化机器学习模型的基础,以下是一些关键步骤:

-

选择合适的编程语言

- C语言:由于其速度极快,C语言适合处理复杂的计算任务。

- Python:虽然Python的编译速度较慢,但通过使用Numpy和Pandas等库,可以显著提升计算效率。

-

优化算法的计算量

- 减少计算量

- 使用更高效的算法(如批处理、并行计算)。

- 删除不必要的变量和操作。

- 减少内存使用

- 优化数据的存储格式,减少内存占用。

- 使用高效的缓存机制。

- 减少计算量

-

使用高效的数学库

- Numpy:快速处理数组运算,显著提升计算速度。

- Pandas:优化数据处理和分析,提高数据处理效率。

-

减少代码的复杂度

- 将复杂的代码拆分为更小的函数,提高可读性和可维护性。

- 使用更简洁的代码结构,减少计算时间。

-

使用高效的运算器

通过编译器优化,如使用Numba或PyTorch的加速功能,提升计算效率。

优化策略:从简单到复杂

-

简单模型优先

- 开始时使用简单的模型(如线性回归、逻辑回归),逐步向复杂模型过渡。

- 简单模型的计算量较小,容易找到瓶颈。

-

数据预处理

正确的数据预处理是优化模型的关键,确保数据质量,减少数据量,提升模型性能。

-

调整参数

调整模型的超参数,优化学习率、批量大小等参数,找到最佳配置。

-

优化算法的计算量

- 使用批处理、并行计算等技术,显著提升计算效率。

- 在PyTorch中使用GPU加速,提升计算速度。

-

部署和测试

- 通过部署工具(如Docker、Kubernetes),将模型快速部署到目标系统。

- 使用工具(如TensorBoard、TensorBoard GPU)实时监控模型性能。

模型优化后的性能表现

通过上述步骤,CPU核心数为三的模型可以在训练和推理过程中表现出色,以下是优化后的性能表现:

-

训练速度

训练时间大幅缩短,模型快速达到最佳性能。

-

推理速度

推理时间显著降低,模型在推理过程中更加高效。

-

资源利用率

CPU核心数被高效利用,避免资源浪费。

-

模型稳定性

优化后的模型在不同训练和推理过程中表现出稳定性,减少模型波动。

掌握这些技巧,实现机器学习的高效运行

CPU核心数为三的现象并不是模型性能的上限,而是可以通过合理配置代码和优化算法,实现的高效运行,关键在于:

- 正确选择编程语言和库。

- 优化算法和数据处理。

- 使用高效的运算器和工具。

通过以上技巧,您可以在机器学习模型的训练和推理过程中实现更大的效率提升,为机器学习的发展贡献力量。